现在越来越多的人抱怨说搜索引擎收录很难做,站群程序似乎不在是那么重要,花费高价购买域名成为了做出高收录站群的越来越重要的建站前提。

事实上好的程序也必不可要的因素的之一,一套好的站群程序就不仅可以更好的留住抓取页面的蜘蛛,在索引后还有更好的排名展示。

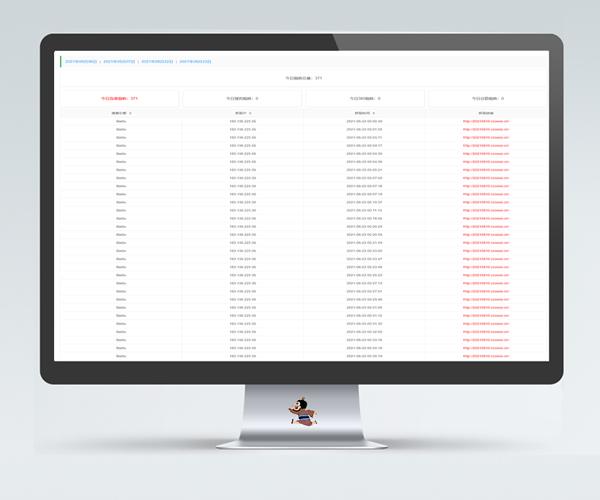

最近做搜狗泛域名程序的站点的人非常多,这是一套适用于搜狗的分城市站群程序,泛域名+泛目录实现泛收录。

本程序类似于《超度小说站群程序》,自带蜘蛛统计插件(zz.php),自带php一键配置文件(configure.php)。

发布日期:2021-08-23 16:24:19

最后更新日期:2022-03-06 22:58:57

演示站

演示说明:请不要用本程序从事任何违法行为!

特别说明:由于没有那么多闲置域名,所以本演示站是用二级域名搭建的。因此本程序在演示站中可以展现内页,并不能很好的展现分城市泛二级的功能。泛二级的首页及内页模板均参照现有域名的主页及内页。

1.演示站点非站内链接,请自行复制访问,仅作程序/源码演示,不作为其他任何用途;

2.演示站点为源程序的代码,站点内的任何内容与我站无关,所有内容均非我站观点,如有违法、不雅内容,请联系我站删除;

3.演示站点为二级域名,因此演示站或存在二级域名、二级目录无法正常打开的情况,故不能完全演示;

4.演示站点具有时效性,站长仅能保证安装时所有文件可用,如采集php文件、推送php文件等,不能保证源采集点还能使用;

5.请认真参阅演示站点,如有个别页面/文件无法打开的,大多属于源程序存的问题,购买即视为认可,不在售后范围;

6.演示站点使用robots.txt屏蔽所有搜索引擎抓取,不能视为该站群程序的使用后的实际效果;

提示:原程序非我站编写,乃是热心网友提供,如有侵权万分抱歉,请联系我们删除!

程序简介

是否开启游客访问的功能绝大部分程序都拥有,这里不去细谈。

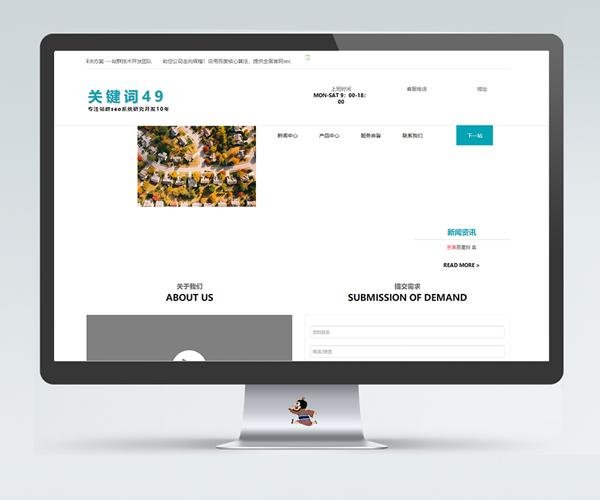

程序的亮点之一在于自带蜘蛛统计和强引功能,可以根据您的设置选择是否强引蜘蛛,并选择强引哪个具体IP段落的蜘蛛,可以自定义设置触发强引蜘蛛的概率,并可以自定义外链类型。

蜘蛛统计展示:zz.php

代码展示:configure.php

<?php /*================= 配置选项 ===================*/ $astrict="0"; // 限制访问功能 1=只能蜘蛛访问 0=访客+蜘蛛访问 $citation="0"; // 是否开启蜘蛛强引功能 1=开启 0=关闭 $spider_type="3"; // 指定蜘蛛: 1=百度蜘蛛 2=360蜘蛛 3=搜狗蜘蛛 4=谷歌蜘蛛 $spider_ip="0"; // 指定蜘蛛IP,根据spider文件夹重要IP抓取 $chance="80"; // 蜘蛛强引概率,1到100的概率设置,100为100% $link_type="2"; // 强引外链类型,1=系统外链 2=自定义外链,自定义外链到根目录hret.txt文件设置,一行一条 /*================= 配置结束 ===================*/ ?>

分城市泛域名也是本程序的亮点之一,前台看模板有些类似于58同城这些网站的风格。

在首页模板的最后,类似于footer位置,有强引蜘蛛的链接,这里不去截图了,具体可以参考查看演示站。

安装说明

程序无数据库,直接上传到网站根目录,填写好伪静态即可,默认开启抓取/访问即缓存。

Nginx伪静态

rewrite /index.html$ /index.php; rewrite ^/(.*).html /404.php; rewrite ^/(.*).xml$ /sitemap.php?id=$1;

程序目录文件

所见即所得,下载后您将得到以下截图内的程序文件:

程序架构及说明

<分城市搜狗泛站群> ├404.html ├404.php ├config.php ├configure.php 用户自定义配置文件,上文中已经展示了本文件 ├hret.txt 请注意用户自定义外链放在这里 ├index.html ├index.php ├nginx.htaccess ├robots.txt ├sitemap.php xml地图文件 ├sogou.css ├sogou1.css ├zz.php 蜘蛛统计展示页面,访问本文件展示蜘蛛 ├<301> ├<news> │ └data.txt ├<pics> 模板中需要调用到的图片库 ├<simple> │ ├change_log.txt │ ├composer.json │ ├simple_html_dom.php │ ├<app> │ ├<example> │ ├<manual> │ ├<testcase> ├<spider> 统计及屏蔽蜘蛛的IP段,默认已经设置好了,基本上不需要修改 │ ├baidu.txt │ ├google.txt │ ├sll.txt │ └sougou.txt ├<style> │ ├<css> │ ├<images> ├<style1> │ ├<css> ├<sypseo> 这个文件夹注意看咯! │ ├dirCache.class.php │ ├<cache> 缓存文件,游客访问也会生成缓存,可以删除本文件夹达到删除缓存的目地 │ ├<dom> 本程序绑定的根域名写在本文件中,一行一条 │ │ └domains.txt │ ├<jsc> │ │ └dongtai.txt │ ├<keywords> 关键词文件库 │ ├<map> │ │ └map.html │ ├<newslinks> │ │ └newslinks.txt │ ├<shipin> │ │ └shipin.txt │ ├<spider> 蜘蛛统计文件 │ ├<tpl> 模板文件 │ │ ├<neirong> 内页模板文件 │ │ │ ├books.php │ │ │ └fanjiexi.html │ │ ├<shouye> 首页模板文件 │ │ │ ├books.php │ │ │ └fanjiexi.html │ ├<wailian> 外链库 │ │ └wailian.txt ├<zhizhu> 如果有蜘蛛访问网站,将在本目录下生成log文件,如果想清除统计,可以删除本文件夹内的内容

下载链接

下载仅供技术交流、学习探讨,请勿用于非法用途!请在下载后24小时内删除!

收取费用仅为整理编辑及维护本站运营相关成本(服务器租赁、CDN防护、人工客服等成本)的赞助与支持!

站群SEO » 分城市搜狗泛站群/自带蜘蛛统计和蜘蛛强引