有时候我们使用域名搭建一些居间站点,或应用于跳转,或是其他需求。

往往这些页面不被主流搜索引擎认可,动不动给域名报毒,在qq等聊天软件中报红,浏览器报毒不让打开。

有的这些站点会有些许流量,如果被爆红爆毒会对我们的使用造成困恼,我们不需要被搜索引擎抓取收录更不需要排名,所以我们可以禁止主流的蜘蛛抓取,而游客访问则不受到干扰。

正常情况下域名爆红都是robot爬虫扫描并检测到敏感内容导致的,往后的审核或是爬虫审核,或是人工审核,如果是前者,在不影响正常使用的情况下,我们屏蔽爬虫抓取则显得很有必要。

很多时候尽管我们写了robots.txt,申明禁止任何爬虫抓取,但实际上还是会产生收录。使用伪静态跳转403页面的方式更为简单暴力。

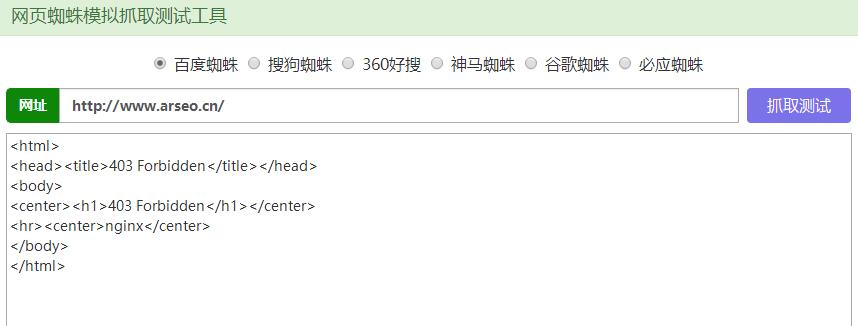

如曹操SEO网站的演示站,使用此代码后将不在主流搜索引擎收录,模拟蜘蛛抓取后返回403提示,如下图:

我们在伪静态中写下如下代码在第一行:

if ($http_user_agent ~* (SemrushBot|DotBot|HttpClient|MJ12bot|SemrushBot|Barkrowler|AhrefsBot|PetalBot|BLEXBot|SM-G900P|Baiduspider|sogou|360|Googlebot|YisouSpider|SOSOsosospider|Bingbingbot|youdaobot)) {

return 403;}记住一定要按写在伪静态的第一行哦!

本站所有内容仅限用于学习和研究目的,程序仅供本地断网测试,转载请说明出处!

站群SEO » 通过伪静态屏蔽主流蜘蛛返回403的方法

站群SEO » 通过伪静态屏蔽主流蜘蛛返回403的方法